چندی قبل یک ماشین خودران عجیب و غریب در خیابان های ساکت و آرام نیوجرسی آمریکا به حرکت درآمد. آن ماشین در واقع حاصل تلاش محققان انویدیا بود و تفاوت چندانی هم با دیگر اتومبیل های سطح خیابان نداشت، با این همه کاملا متمایز از تلاش های قبلی گوگل، تسلا و جنرال موتورز بود و سعی می کرد قدرت هوش مصنوعی را به همگان نشان دهد.

ماشین انویدیا دستورالعمل واحدی که از جانب یک مهندس یا برنامه نویس در اختیارش قرار گرفته باشد را دنبال نمی کرد و در مقابل تماما به الگوریتمی متکی بود که به آن یاد داده بود با نگاه کردن به یک راننده، راه و روش کار را فرا بگیرد.

اینکه ماشینی با این مشخصه بسازید، در نوع خود بی نظیر است اما از سویی هم می توان این موفقیت را نگران کننده خواند چراکه دقیقا مشخص نیست ماشین تصمیمات خود را بر چه اساسی می گیرد.

اطلاعات به دست آمده از سنسورهای ماشین مستقیما برای شبکه عظیمی از عصب های مصنوعی ارسال می شوند که داده ها را پردازش کرده و سپس فرامین مورد نیاز را برای هدایت فرمان، ترمزها و دیگر سیستم ها صادر می کند.

عملکرد این ماشین ظاهرا با واکنش هایی که از یک راننده انتظار می روند برابری می کردند، اما چه می شود اگر روزی رفتارهایی غیرمنتظره از ماشین سر بزند و مثلا خود را به درختی بکوبد یا اینکه با سبز شدن چراغ راهنمایی و رانندگی به حرکت در بیاید؟

با در نظر داشتن دانسته های امروزمان، در صورت بروز این اتفاق شاید به سختی بتوان علت را تشخیص داد. این سیستم آنقدر پیچیده است که حتی مهندسانی هم که آن را طراحی کرده اند ممکن است برای یافتن علت بروز رفتارهای مختلف در آن با مشکل روبرو باشند. از طرفی شما هم نمی توانید خواستار آن شوید چراکه هم اکنون هیچ روش روشنی برای طراحی چنین سیستمی به نحوی که علت رفتارهایش را توضیح دهد وجود ندارد.

ذهن مرموز این ماشین در اصل به یک موضوع مهم در زمینه هوش مصنوعی اشاره دارد. تکنولوژی هوش مصنوعی مورد استفاده در آن که تحت عنوان یادگیری عمیق از آن یاد می گردد ثابت کرده که طی سالیان اخیر در حل مشکلات بسیار موفق و قدرتمند بوده و به صورت گسترده برای انجام اموری نظیر افزودن توضیحات به عکس، تشخیص صدا و ترجمه زبان مورد استفاده قرار گرفته است.

حالا بشر امیدوار است که به لطف آن امکان تشخیص بیماری های مرگبار را پیدا کند و تصمیمات تجاری چندین میلیون دلاری بگیرد و بسیاری کارهای دیگر را انجام دهد که هر کدام می توانند یک صنعت را دگرگون کنند.

اما این اتفاق رخ نخواهد داد یا دست کم تا زمانی تکنولوژی هایی نظیر یادگیری عمیق برای خالقانشان قابل درک تر شوند و اطمینان پذیری بالاتری برای کاربرانشان پیدا کنند، نباید رخ بدهد. در غیر اینصورت احتمالا تشخیص اینکه چه زمانی خطا رخ می دهد [که بروز خطا هم قطعا هم غیر قابل اجتناب است] بسیار دشوار خواهد شد. این در واقع یکی از دلایلی است که می توانیم بگوییم ماشین طراحی شده توسط انویدیا هنوز هم در مرحله تست و تجربه قرار دارد.

در حال حاضر، برای تشخیص اینکه چه فردی شایسته دریافت وام است یا چه کسی استخدام می شود از الگوهای ریاضی پیشتر طراحی شده استفاده می گردد. اگر بتوانیم به این الگوها دسترسی پیدا کنیم آنگاه شاید بتوانیم نحوه استدلال آنها را تشخیص دهیم. با این همه، بانک ها، ارتش های جهان، کارفرمایان و دیگران اندک زمانی است که تمرکز خود را معطوف به رویکردهای پیچیده تر یادگیری ماشینی کرده اند که این مساله در نهایت می تواند تصمیم گیری های خودکار آنها را پیچیده تر از همیشه کند.

یادگیری عمیق که حالا مرسوم ترینِ این رویکردها محسوب می شود معرف روشی کاملا متفاوت برای برنامه ریزی ماشین هاست.

به گفته تامی جاکولا، یکی از اساتید MIT که روی کاربردهای یادگیری ماشینی تحقیق می کند: این مشکلی است که هم اکنون وجودش حس می شود و انتظار می رود که در آینده بر اهمیت آن افزوده شود. فرقی ندارد که تصمیم شما به سرمایه گذاری مربوط باشد یا حوزه پزشکی و یا حتی نظامی، در هر صورت نیازی نیست که روی یک روش تست جعبه سیاه تمرکز شود.

برخی بر این باورند این حق ماست که در مورد یک سیستم هوش مصنوعی تحقیق و بررسی کنیم تا دریابیم که سازوکار آن چیست. با در نظر داشتن همین مساله، پیش بینی می شود که اتحادیه اروپا احتمالا از سال 2018 میلادی تمامی شرکت های اروپایی را ملزم نماید که توضیحات لازم را در مورد تصمیماتی که به خودکار شدن سیستم ها منتهی شده، به کاربران خود ارائه دهند.

البته شاید این امر حتی برای سیستم های ساده و سطحی نظیر اپلیکیشن ها و وبسایت هایی که از یادگیری عمیق برای نمایش تبلیغات و پیشنهاد موسیقی به کاربران استفاده می کنند، عملیاتی نباشد. در واقع کامپیوترهایی که این سرویس ها را ارائه می دهند خودشان، خود را برنامه ریزی کرده اند و این کار را به روشی انجام داده اند که قابل درک نیست. جالب است بدانید حتی مهندسانی که این اپلیکیشن ها را توسعه داده اند هم توضیحات جامعی در رابطه با رفتار آنها در اختیار ندارند.

همین مساله پرسش هایی را در ذهن به وجود می آورد که هوش از سر انسان می برند. با پیشرفت تکنولوژی انسان ممکن است از آستانه هایی رد شود که در آن سوی آنها، هوش مصنوعی وی را به رد شدن از اخلاقیات وادار نماید.

البته تردیدی نیست که ما به عنوان انسان هیچگاه نمی توانیم فرایندهای ذهنی مان را به درستی توضیح دهیم، با این همه راه هایی را می یابیم تا به واسطه آنها به افراد مختلف اعتماد کرده و آنها را ارزیابی نماییم.

اما آیا این امر در رابطه با ماشین هایی که تفکر و تصمیم گیری شان کاملا متفاوت از انسان است هم صادق خواهد بود؟ تا پیش از این ماشین هایی که عملکردشان برای بشر قابل درک نباشد، ساخته نشده اند. با در نظر داشتن این مساله، انتظار دارید ارتباط ما با ماشین های هوشمندی که می توانند غیرقابل پیش بینی و نفوذناپذیر باشند، تا چه اندازه مطلوب باشد؟

این تصویر را هنرمندی به نام آدام فریس با استفاده از گوگل دیپ دریم ساخته است؛ این برنامه تصاویر را به گونه ای اصلاح می کند که توانمندی های تشخیص الگوی شبکه عصبی عمیق را تحریک نمایند. تصویری که در بالا می بینید هم با استفاده از یک لایه میانی در شبکه عصبی مذکور تولید شده است.

در سال 2015 میلادی، یک تیم تحقیقاتی در بیمارستان Mount Sinai نیویورک تصمیم گرفت که یادگیری عمیق را روی دیتابیس عظیم سوابق پزشکی بیماران خود مورد استفاده قرار دهد.

این داده ها نیز صدها متغیر در مورد بیماران را شامل می شد که از نتایج آزمایشات انجام شده روی آنها گرفته تا ویزیت شان با پزشکان و مواردی از این دست را شامل می شد.

برنامه تولید شده برای این منظور که محققان نام Deep Patient را برایش انتخاب کرده بودند با استفاده از داده های به دست آمده از حدود هفتصد هزار بیمار آموزش داده شد و وقتی عملکرد آن روی دیتای جدید مورد ارزیابی قرار گرفت، مشخص شد که در تشخیص بیماری بسیار موفق و خوب ظاهر می شود.

در واقع Deep Patient بدون دریافت هرگونه دستورالعمل تخصصی موفق شد الگوهای پنهان در دیتای بیمارستان را تشخیص دهد و این الگوها نشان می دادند افراد مختلف چه زمانی به سمت ابتلا به بیماری های مزمن نظیر سرطان کبد پیش می روند. به گفته Joel Dudley که مدیریت تیم Mount Sinai را بر عهده داشته: روش های مختلفی وجود دارند که پیش بینی بیماری از روی سوابق پزشکی افراد را ممکن می کنند اما این روش از همه بهتر است.

در عین حال، Deep Patient اندکی نیز عجیب عمل می کند. برای نمونه ظاهرا شروع اختلالات روانی نظیر شیزوفرنی را به طرزی باور نکردنی خوب تشخیص می دهد اما چون پیش بینی این بیماری برای روانپزشکان بسیار دشوار است، Dudley از این توانمندی هوش مصنوعی ابداعی خود به شدت شگفت زده شد. او هنوز هم علت این توانایی را نمی داند و مدعی است هیچ نشانه ای دال بر اینکه چطور این اتفاق رخ می دهد در دست نیست.

اگر قرار باشد تکنولوژی خاصی نظیر Deep Patient پزشکان را در تشخیص بیماری یاری دهد، در ایده آل ترین حالت ممکن باید منطق و استدلالش برای ارائه آن پیشگویی را در اختیارشان قرار دهد و از این طریق اطمینان کافی را به اطبا بدهد که تشخیصش صحیح بوده و دلایل موجهی برای تغییر نوع داروهای مصرفی یک فرد بیمار در اختیار دارد.

Dudley با تاسف می گوید: ما می توانیم این مدل ها را بسازیم اما نمی دانیم که دقیقا چطور کار می کنند.

البته باید اضافه کنیم که هوش مصنوعی هیچگاه اینطور نبوده است. از همان ابتدا، دو مکتب فکری در رابطه با قابل درک بودن و قابل توضیح بودن آن وجود داشت. بسیاری بر این باور بودند که عقلانی تر آن است ماشین هایی ساخته شوند که براساس قوانین و منطق موجود استدلال می کنند و فعالیت های درونی شان هم باید برای هر فرد کنجکاوی کاملا شفاف باشد.

دیگران اما احساس می ردند که اگر این ماشین ها از بیولوژی الهام بگیرند و از طریق مشاهده و تجربه بر دانسته هایشان اضافه گردد، آنگاه با سهولت بیشتری از هوش بهره مند می شوند و این یعنی تحول تمام و کمال برنامه نویسی کامپیوتری.

بنابراین به جای آنکه یک برنامه نویس برای حل مشکل برنامه ای، کد بنویسد، برنامه الگوریتم های خود را براساس دیتای نمونه تولید و یک خروجی مطلوب را ارائه می کند. تکنیک های یادگیری ماشینی که بعدها به ایجاد قدرتمندترین سیستم های هوش مصنوعی منجر شدند، روش دوم را انتخاب نمودند: یعنی ماشین هایی که خودشان را برنامه ریزی می کردند.

در ابتدای امر این رویکرد کاربرد عملیاتی محدودی داشت و در دهه 1960 و 70 میلادی با محدودیت های گسترده ای روبرو بود. اما طولی نکشید که با کامپیوتری شدن بسیاری صنایع و البته ظهور پایگاه های داده ای عظیم علاقه به این حوزه نیز تجدید شد و به این ترتیب تکنیک های قدرتمندتری برای یادگیری ماشینی ابداع گردید و به طور مشخص اشکال تازه ای از شبکه های عصبی هوش مصنوعی ابداع گردید.

تا دهه 1990 میلادی، شبکه های عصبی موفق شدند که به صورت خودکار کاراکترهای دست نویس را به صورت دیجیتالی در بیاورند.

اما از ابتدای همین دهه و بعد از چندین فرایند بهینه سازی بود که شبکه های عصبی بسیار عظیم یا عمیق توانمندی های خاص خود را در زمینه درک خودکار به نمایش گذاشتند.

حالا یادگیری عمیق را می توان ریشه اصلی شکوفایی هوش مصنوعی دانست. این دستاورد قدرتی ماورایی به کامپیوترها بخشیده و برای نمونه امکان تشخیص کلمات در محاوره [آن هم به خوبی انسان] را در آنها ایجاد کرده است. همانطور که تایید می کنید کدنویسی برای این مهارت کاری بس دشوار و پیچیده است.

یادگیری عمیق دید کامپیوتری را هم متحول کرده و ترجمه ماشینی را به سطوح تازه ای از پیشرفته رسانده است. حالا از این تکنولوژی برای تصمیم گیری های بزرگ در علم پزشکی، فاینانس، تولید و فراتر از آن استفاده می شود.

اما عملکرد تکنولوژی های یادگیری ماشینی نسبت به هر سیستم دیگری که با دست برای آن کدنویسی شده باشد حتی در نظر دانشمندان علوم کامپیوتر نیز ناشناخته و مبهم است.

البته این بدان معنا نیست که تکنیک های هوش مصنوعی آینده به همین میزان غیرقابل شناخت خواهند بود بلکه منظور آن است که یادگیری عمیق مشخصا یک جعبه سیاه تاریک است.

به بیان دیگر نمی توان با نگاه کردن به درون یک شبکه یادگیری عمیق از عملکرد آن سر درآورد. منطق و استدلال یک شبکه درون رفتار هزاران عصب شبیه سازی شده قرار گرفته که آنها نیز درون ده ها یا صدها لایه متصل به هم جای دارند.

عصب یا نرون هایی که درون لایه نخست قرار دارند هرکدام یک دیتای اولیه را دریافت می کنند (مثلا تراکم پیکسل ها درون یک تصویر) و سپس قبل از آنکه سیگنال تازه ای را ارائه دهند، یک عملیات محاسباتی را انجام می دهند. در ادامه دیتای خروجی در داخل یک شبکه پیچیده در اختیار نرون های موجود در لایه بعدی قرار می گیرند و این روند ادامه می یابد تا اینکه یک خروجی کلی ایجاد می شود.

علاوه بر این، فرایند دیگری به نام پس-انتشار وجود دارد که محاسبات صورت گرفته توسط یک نرون را دستکاری و امکانی را برای شبکه فراهم می کند تا یک خروجی مطلوب ایجاد کند.

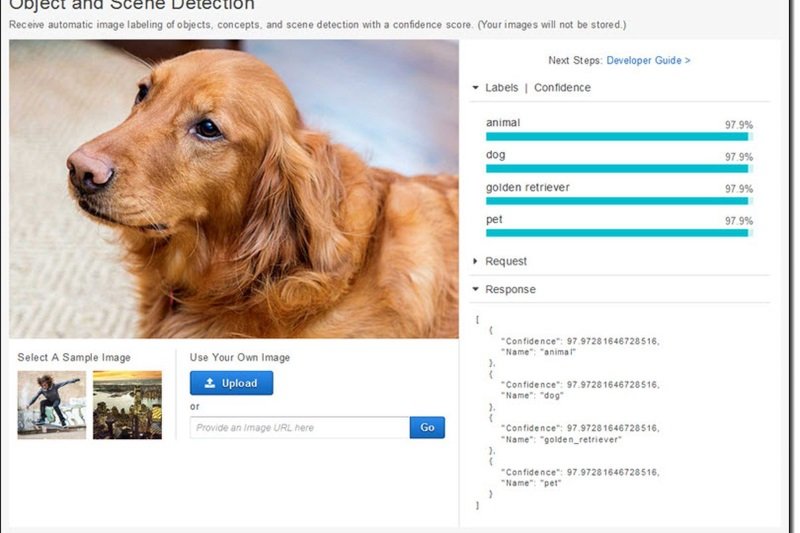

لایه های متعددی که درون یک شبکه عمیق وجود دارند امکانی را برای آن فراهم می کنند تا مسائل را در سطوح مختلف یک مفهوم تشخیص دهد. برای مثال در سیستمی که برای شناسایی سگ ها طراحی شده، لایه های پایینی امور ساده ای نظیر رنگ را تشخیص می دهند و لایه های بالایی موارد پیچیده تری مانند حالت چشم ها یا موی بدن سگ را شناسایی می کنند و بالاترین لایه نیز تمامی این موارد را در کنار هم با عنوان یک سگ تشخیص می دهد.

همین رویکرد را هم می توان در مورد ماشینی که به خود آموزش می دهد، در نظر گرفت: صداهایی که کلمات موجود در یک زبان را می سازند، حروف و کلماتی که جملات یک متن را می سازند و حتی حرکات مربوط به فرمان که در رانندگی باید انجام شوند.

تا به امروز استراتژی های مبتکرانه ای در پیش گرفته شده تا جزئیات اتفاقاتی که درون این سیستم ها رخ می دهد را تشخیص داده و توضیح مناسبی برایشان پیدا کنند. در سال 2015 میلادی، محققان گوگل بهینه سازی هایی را در الگوریتم تشخیص تصویر مبتنی بر یادگیری عمیق خود اعمال کردند به نحوی که الگوریتم به جای تشخیص اشیاء درون عکس ها آنها را تولید یا اصلاح می کرد.

آنها با اجرای برعکس الگوریتم توانستند فاکتورهایی که برنامه برای شناسایی یک پرنده یا ساختمان به کار می برد را تشخیص دهند.

با این همه، تصاویری که از این طریق توسط پروژه دیپ دریم تولید شدند بسیار عجیب بودند و برای نمونه از ابرها و گیاهان شکل مربوط به موجوداتی غریب ایجاد می شد.

تصاویر ایجاد شده در واقع ثابت کردند که یادگیری عمیق تا چه اندازه از درک انسان فاصله دارد. محققان گوگل نیز خاطرنشان کردند که وقتی الگوریتم های آن عکس هایی را از یک دمبل تولید کردند، همزمان تصویری از بازوی انسان که آن دمبل را در دست داشت هم ساختند. در واقع استدلال ماشین این بود که بازوی انسان بخشی از دمبل است.

در ادامه دانشمندان با کمک ایده های اقتباس شده از علم عصب شناسی و علوم شناختی، به پیشرفت های بیشتری دست پیدا کردند. تیمی به رهبری جف کلان، (از استادیاران دانشگاه Wyoming) با استفاده از نوعی هوش مصنوعی اقدام به تست شبکه های یادگیری عمیق کرد. در سال 2015 میلادی، این تیم نشان دادند که برخی عکس های خاص چطور می توانند چنین شبکه ای را فریب دهند تا چیزی هایی که وجود ندارند را درک کند. علت در واقع این بود که برای این منظور سیستم به دنبال الگوهای سطح پایین و ساده ای می گشت.

یکی از همکاران کلان به نام جیسون یوسینسکی همچنین ابزاری ساخته بود که مانند نوعی کاوشگر درون یک مغز عمل می کرد. ابزار او در اصل هر نورونی که در میانه شبکه قرار داشت را هدف قرار می داد و به دنبال عکس هایی می گشت که بیشتر از همه آن را فعال می کردند.

به همین خاطر تصاویری که پیدا می شدند شکلی انتزاعی داشتند (مثلا نمایی امپرسیونیستی از یک اتوبوس مدرسه را در نظر بگیرید) و ماهیت مرموز توانمندی های ادراکی ماشین را به تصویر می کشیدند.

روشن است که انسان به چیزی فراتر از یک شناخت کلی نسبت به تفکر هوش مصنوعی نیاز دارد و متاسفانه برای این منظور هم راهکار ساده ای وجود ندارد. در واقع برای تشخیص الگوهای سطح بالا و تصمیم گیری های پیچیده به اثر متقابل محاسبات درون یک شبکه عصبی عمیق نیاز است، اما مساله اینجاست که آن محاسبات دریایی از توابع و متغیرهای ریاضی را در خود دارند.

جاکولا در این باره می گوید:

اگر با یک شبکه عصبی بسیار کوچک سر و کار داشتید آنگاه کار راحت بود و شاید می شد آن را درک نمایید، اما وقتی آن شبکه بیش از حد بزرگ می شود و در هر لایه اش هزاران واحد وجود داشته باشند، آنگاه برایتان غیرقابل درک خواهد شد.

در دفتر مجاور به محل کار جاکولا، یکی از اساتید MIT به نام رجینا بارزیلای زندگی میکند و او تصمیم دارد تا یادگیری ماشینی را در علم پزشکی به خدمت بگیرد. حدودا دو سال قبل بود که پزشکان تشخیص دادند به سرطان سینه مبتلاست. خود این تشخیص به اندازه کافی برای او ناراحت کننده و عجیب بود اما عجیب تر اینکه متوجه شد در تحقیقات آنکولوژی و درمان بیماری، هیچ استفاده ای از داده های پیشرفته و روش های مبتنی بر یادگیری ماشینی نمی شود.

او می گوید هوش مصنوعی از توان بالایی برای متحول نمودن علم پزشکی برخوردار است و این یعنی باید پای از سوابق پزشکی فراتر نهاده شود. او آینده ای را متصور می شود که در آن، از داده های خام بیشتری که هم اکنون کاربردی ندارند استفاده گردد و برای نمونه به دیتای تصویربرداری و یا پاتالوژی اشاره می کند.

وی بعد از اتمام دوره درمانی خود به همراه تیمی از محققان شروع به توسعه سیستمی با قابلیت تفحص و جستجو در گزارشات پاتولوژی کرد تا خصوصیات بالینی خاصی که محققان ممکن است علاقمند به مطالعه شان باشند را شناسایی کند.

با این همه، او می دانست که سیستم باید استدلال های خود را ارائه نماید و به همین خاطر، همراه با جاکولا یک گام دیگر را به فرایند توسعه آن افزود که به موجب آن، سیستم کوچک ترین متونی که می توانند معرف الگوی احتمالی از بیماری باشند را از گزارشات اقتباس و مشخص نماید.

آنها همچنین مشغول توسعه نوعی الگوریتم یادگیری عمیق هستند که قادر است علائم اولیه سرطان سینه را در تصاویر ماموگرافی فرد تشخیص دهد و امیدوارند امکانی را برای سیستم ابداعی خود فراهم آورند تا بتواند استدلالش در رابطه با تشخیص خود را مطرح نماید.

چطور میتوان با ماشین های غیرقابل درک و نفوذ یک همزیستی مسالمت آمیز داشت؟

در حال حاضر ارتش آمریکا میلیاردها دلار را صرف پروژه هایی می کند که از یادگیری ماشینی برای هدایت ماشین آلات و هواپیماهای جنگی، تشخیص اهداف و بررسی حجم انبوه اطلاعات استفاده می کنند و باید بگوییم که در حوزه نظامی کمترین فضا برای ابهام در الگوریتم ها وجود ندارد.

دیوید گانینگ از مدیران ارشد دارپا که هم اکنون روی پروژه ای به نام هوش مصنوعی قابل توضیح کار می کند و نظارت بر ساخت سیری را در کارنامه فعالیت های حرفه ایش دارد در این باره می گوید: اتوماسیون در حال نفوذ به حوزه های مختلفی از زندگی ماست.

تحلیلگران اطلاعاتی نیز هم اکنون مشغول تست یادگیری ماشینی به عنوان روشی برای تشخیص الگوها در حجم انبوه داده های نظارتی هستند. در حال حاضر ماشین ها و هواپیماهای خودران متعددی در دست ساخت ,و البته تست هستند اما روشن است که سربازان درون تانک اتوماتیکی که علت رفتارهایش را توضیح نمی دهد ابدا احساس راحتی نمی کنند و از آن طرف تحلیلگران هم از تصمیم گیری برپایه اطلاعاتی که هیچ علت مشخصی ندارند، خودداری خواهند کرد.

Gunning در این باره می گوید: این غالبا همان ماهیت سیستم های یادگیری ماشینی است که اخطارهای نادرستی را تولید می کنند به نحوی که یک تحلیلگر اطلاعاتی واقعا به دیتای بیشتری نیاز خواهد داشت تا درک کند که چرا چنین پیشنهادی به وی ارائه شده است.

در ماه های گذشته، دارپا 13 پروژه پیشنهادی از سوی نهادهای دانشگاهی و صنعتی را برای سرمایه گذاری انتخاب کرد که برخی از آنها را می توان با استناد به کارهای انجام شده توسط پروفسور کارلوس گاسترین از دانشگاه واشنگتن انجام داد.

او به همراه همکارانش راهی را پیدا کرده بود که سیستم های یادگیری ماشینی بتوانند استدلال و توضیحات خوبی را در رابطه با خروجی کارشان ارائه دهند.

به بیان دیگر، در این روش، یک کامپیوتر به صورت خودکار مثال هایی را از یک مجموعه داده ای پیدا می کند و آنها را در قالب یک توضیح مختصر و کوتاه عرضه می نماید.

برای نمونه، سیستمی که برای طبقه بندی ایمیل های دریافتی از یک تروریست طراحی شود، ممکن است در جریان پروسه آموزش و تصمیم گیری خود از میلیون ها پیام نمونه استفاده کند.

گروه محققین تحت نظر گاسترین همچنین روش هایی را هم برای سیستم های تشخیص تصویر طراحی کرده بودند که با هایلایت کردن بخش هایی از یک تصویر که از باقی قسمت ها مهم تر به نظر می آمد، می توانست توضیحات مختصری را در رابطه با علت تصمیمش ارائه کند.

یکی از ایراداتی که به این رویکرد و البته موارد مشابه به آن وارد می شود آن است که توضیحات ارائه شده همواره ساده سازی می شوند و این یعنی ممکن است در این حین برخی اطلاعات کلیدی از بین بروند.

گاسترین در این باره می گوید: کل رویای ما رنگ واقعیت به خود نگرفته و آن این است که هوش مصنوعی بتواند با انسان محاوره داشته باشد و توضیحاتی را در اختیارتان قرار دهد. لذا تا ایجاد یک هوش مصنوعی قابل درک هنوز راه درازی در پیش است.

البته ضرورت رسیدن به این نقطه ای صرفا به خاطر استفاده از هوش مصنوعی در بخش هایی نظیر تشخیص سرطان نیست و اگر بنا باشد که تکنولوژی به بخشی همیشگی در زندگی روزمره مان بدل شود لازم است که چنین اتفاقی رخ بدهد.

تام گروبر که تیم سیری در اپل را هدایت کرده در این باره می گوید:

توانایی ارائه توضیحات برای تیم من اهمیت بالایی دارد زیرا به لطف آن سیری باهوش تر از قبل خواهد شد و به یک دستیار مجازی قابل اتکا بدل می گردد.

البته وی از ارائه توضیحات و جزئیات بیشتر در این باره خودداری کرد اما روشن است که درآینده چنانچه پیشنهاد خاصی در مورد یک رستوران را از سیری دریافت کنید حتما تمایل دارید که دلایلش برای این منظور را بدانید.

اما درست همانطور که بسیاری جنبه های وجودی انسان غیرقابل توضیح هستند، این احتمال هم می رود که هوش مصنوعی نتواند علت انجام بسیاری فعالیت هایش را توضیح دهد.

Ruslan Salakhutdinov مدیر تحقیقات هوش مصنوعی اپل و از استادیاران دانشگاه کارنگی ملون در این باره می گوید:

حتی اگر فردی توضیحاتی به نظر منطقی را در رابطه با کردارش به شما ارائه دهد باز هم آن توضیحات ناکامل به نظر می آیند و همین مساله هم در مورد هوش مصنوعی صادق خواهد بود

اگر اینگونه باشد آنگاه شاید باید در پاره ای از موارد به قضاوت های هوش مصنوعی اطمینان کنیم یا کارهایمان را بدون آن انجام دهیم. به همین ترتیب آن قضاوت هم باید دربرگیرنده هوش اجتماعی باشد چراکه جامعه براساس پیمانی از رفتارهای پذیرفته شده استوار است و ما هم باید سیستم های هوش مصنوعی خود را براساس عرف اجتماع طراحی نماییم. پس اگر بناست تانک های رباتیک یا ماشین های قاتل بسازیم ضروری است که تصمیم گیری آنها همگام و همراستا با قضاوت های اخلاقی مان باشد.

در این میان، سایتهایی مانند پیشکاربات به عنوان منابع و ابزارهایی برای دسترسی به خدمات هوش مصنوعی مطرح هستند. پیشکاربات یک پلتفرم مشاور هوش مصنوعی است که کاربردهای متنوعی دارد، از جمله چتبات، تحلیل سوالات، آموزش مداوم ربات ها و ... این سایت با ارائه دسترسی آسان به فناوریهای پیشرفته، به کاربران خود کمک میکند تا از فواید هوش مصنوعی در فعالیتهای روزمره و کسب و کار خود بهرهمند شوند.

پیشبرد فناوری هوش مصنوعی نه تنها زندگی روزمره را برای مردم سادهتر کرده بلکه امکانات و فرصتهای جدیدی را در عرصههای مختلف فراهم آورده است. توسعه و کاربرد هوش مصنوعی، ما را به سطح جدیدی از برقراری ارتباط و تعامل با دنیای اطرافمان رهنمون ساخته است.

https://www.pishkarbot.com